最近,哈工大(深圳)信息学部计算机科学与技术学院-鹏城国家实验室联培博士生常亦谦的论文《Spike4DGS: Towards High-Speed Dynamic Scene Rendering with 4D Gaussian Splatting via a Spike Camera Array》发表于会议The Thirty-Ninth Annual Conference on Neural Information Processing Systems。

论文信息

论文题目:Spike4DGS: Towards High-Speed Dynamic Scene Rendering with 4D Gaussian Splatting via a Spike Camera Array

论文作者:Qinghong Ye, Yiqian Chang(共一), Haoran Xu, Jianing Li, Wei Zhang, Xuan Wang, Yonghong Tian, Peixi Peng

作者单位:北京大学深圳研究生院、哈尔滨工业大学(深圳)、鹏城国家实验室、中山大学(深圳)

论文简介

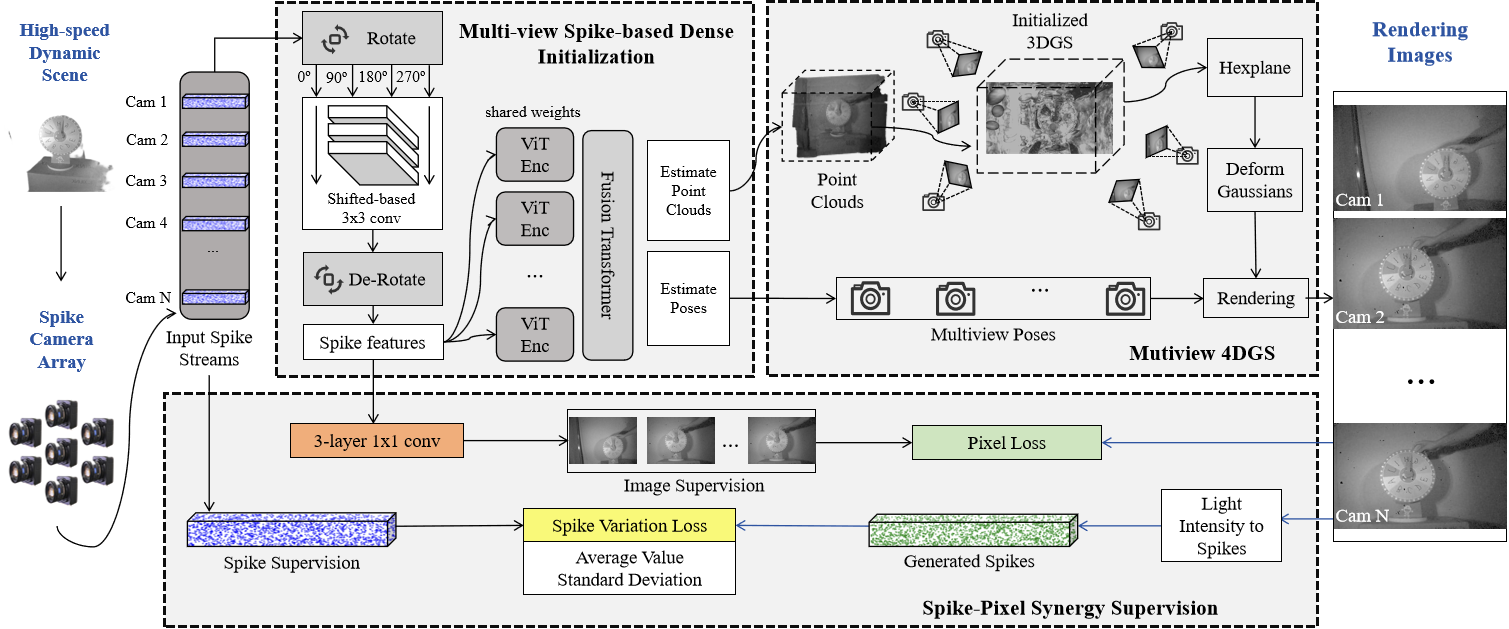

这篇论文第一次提出了使用多个脉冲相机重建高速运动场景的任务。我们使用由9个相机组成的脉冲相机阵列,在20000FPS下对高速运动场景进行了拍摄,并提出了一套面向高速运动过程的4D高斯重建方法Spike4DGS。具体而言,我们首先搭建多视角 spike 相机阵列验证方案可行性,并建立了合成与真实的多视角 spike 重建数据集;随后设计多视角 spike 稠密初始化模块,从连续的 spike 流中获得稠密点云与相机位姿;最后提出spike-像素协同约束监督来优化 Spike4DGS,同时结合渲染图像质量损失与动态时空 spike 损失。实验结果表明,Spike4DGS 在合成与真实数据集上的新视角渲染质量均优于目前的最新方法。作为使用脉冲相机重建高速运动的先驱,我们在这篇论文里建立了完整的实验框架和评价指标,并提出了创新性的高速动态重建算法。

研究动机

高时间分辨率的 spike 相机 为高速动态场景渲染提供了新的视角。现有方法多依赖 Neural Radiance Fields (NeRF) 或 3D Gaussian Splatting (3DGS),并在单目 spike 相机下针对静态场景展开;然而,这类方法在处理动态运动时表现欠佳,而单相机的空间覆盖受限亦难以重建高速场景中的细节。为此,我们提出 Spike4DGS——首个基于 spike 相机阵列、采用 4D Gaussian Splatting 的高速动态场景渲染框架。

主要贡献

l 我们提出 Spike4DGS,首次将 spike 相机阵列与 4DGS 相结合,实现了高速动态场景下的新视角合成。

l 我们提出 Spike–Pixel 协同监督(Spike-Pixel Synergy Supervision),用于优化 Spike4DGS 的参数,提升渲染质量。

l 我们搭建了 spike 相机阵列,并构建了高度逼真的合成与真实多视角 spike 数据集。我们相信这两套标准化数据集将为该新问题的研究开辟新的机会。

方法简述

我们提出的 Spike4DGS 框架在真实世界的 spike 流与动态场景渲染图像之间建立了关联。输入的多视角 spike 流首先进入多视角基于 spike 的稠密初始化模块,以估计点云与相机位姿。在此初始化之上,我们采用结合像素损失(Pixel Loss)与Spike 变化损失(Spike Variation Loss)的Spike–Pixel 协同监督来优化 4DGS 渲染。依托上述设计,Spike4DGS 能够重建高速动态场景,并细致还原其运动与纹理细节。

基于多目脉冲相机高速运动三维重建

l 多目spike相机阵列:该 spike 阵列由 9 台 spike 相机组成,能够以 250×400 的空间分辨率和 20 kHz 的时间分辨率采集 spike 流。在数据采集过程中,我们对 9 台相机进行同步录制,以确保同一运动在不同视角下具有一致的表征。采集时,我们固定相机阵列位置,将高速动态物体置于阵列前方;随后对每个真实场景中包含高速物体的情况,分别录制约 0.5 秒 的 9 路 spike 流。

多目脉冲相机阵列

l 多视角基于 spike 的稠密初始化:以 spike 相机为基础的既有渲染任务通常采用两阶段初始化:首先利用spike→图像方法生成图像;随后在这些图像上进行场景初始化。然则,该两阶段流程复杂且高度依赖 spike→图像转换的质量。面对高速动态场景时,转换图像中纹理细节的缺失会进一步影响最终的点云估计。与之相对,我们提出端到端框架 MSDI(Multi-view Spike-based Dense Initialization),由 spike 特征提取器、点云与位姿估计器以及图像生成器组成。作为一个端到端网络,MSDI 在 Carla模拟器采集的多视角 spike 流上,结合预训练权重进行微调。

l Spike–Pixel 协同监督:传统三维重建的像素损失仅关注图像相似性,忽略了蕴含在 spike 流中的纹理与运动细节。在高速运动的新视角渲染问题中,纹理和更细微的运动是需要捕捉的。因此,为利用 spike 的特性,我们提出spike 变化损失(spike variation loss):先将渲染图像转换为 spike 流,再与真实 spike 流进行变化幅度/模式对比以度量差异,这个损失函数与像素损失协同监督,保证细致还原其运动与纹理细节。

实验结果

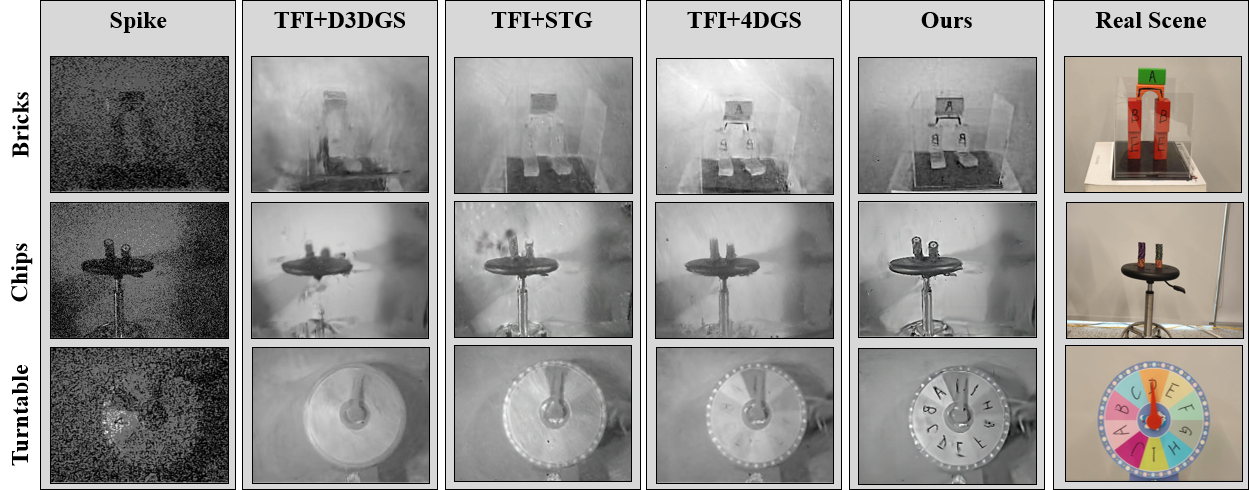

实验结果表明,Spike4DGS 在合成与真实数据集上的新视角渲染质量均优于目前的最新方法。我们主要与若干 SOTA 方法进行对比。相比之下,我们的方法同时呈现出更优的轮廓与更清晰的细节。

高速运动场景的重建效果

总结

本文提出 Spike4DGS,一种将多路 spike 阵列采集的 spike 流无缝融入 4DGS 训练的全新框架,针对高速动态场景重建中的关键挑战给出有效解决方案。Spike4DGS 设计了多视角基于 spike 的稠密初始化(MSDI)模块,用于从连续 spike 流中获取稠密点云;同时提出Spike–Pixel 协同监督策略,以优化模型参数、提升渲染质量。我们还构建了两套全新数据集并进行了全面评测。实验结果表明,在高速动态场景中,Spike4DGS 的重建质量优于以往的 SOTA 动态重建方法,且在训练开销与渲染帧率(FPS)上几乎无额外损失。

该研究工作获得了鹏城实验室重点项目、北京大学深圳研究生院和广东省安全智能新技术重点实验室的支持。